İstatistik

| İstatistikler |

|---|

|

|

İstatistik, verilerin toplanması, düzenlenmesi, analizi, yorumlanması ve sunulması ile ilgilenen bir disiplindir. İstatistiği bilimsel, endüstriyel veya sosyal bir probleme uygularken, çalışılacak bir istatistiksel popülasyon veya istatistiksel bir model ile başlamak gelenekseldir. Popülasyonlar, "bir ülkede yaşayan tüm insanlar" veya "bir kristali oluşturan her atom" gibi çeşitli insan grupları veya nesneler olabilir. İstatistik, anketlerin ve deneylerin tasarımı açısından veri toplamanın planlanması da dahil olmak üzere verilerin her yönüyle ilgilenir. ⓘ

Nüfus sayımı verileri toplanamadığında, istatistikçiler belirli deney tasarımları ve anket örnekleri geliştirerek veri toplarlar. Temsili örnekleme, çıkarımların ve sonuçların örneklemden bir bütün olarak popülasyona makul bir şekilde yayılabilmesini sağlar. Deneysel bir çalışma, incelenen sistemin ölçümlerini almayı, sistemi manipüle etmeyi ve ardından manipülasyonun ölçümlerin değerlerini değiştirip değiştirmediğini belirlemek için aynı prosedürü kullanarak ek ölçümler almayı içerir. Buna karşılık, gözlemsel bir çalışma deneysel manipülasyon içermez. ⓘ

Veri analizinde iki ana istatistiksel yöntem kullanılır: ortalama veya standart sapma gibi indeksler kullanarak bir örneklemden elde edilen verileri özetleyen tanımlayıcı istatistikler ve rastgele değişkenliğe (örneğin, gözlem hataları, örnekleme değişkenliği) tabi olan verilerden sonuçlar çıkaran çıkarımsal istatistikler. Tanımlayıcı istatistikler çoğunlukla bir dağılımın (örneklem veya popülasyon) iki grup özelliği ile ilgilenir: merkezi eğilim (veya konum) dağılımın merkezi veya tipik değerini karakterize etmeye çalışırken, dağılım (veya değişkenlik) dağılımın üyelerinin merkezden ve birbirlerinden ne ölçüde ayrıldığını karakterize eder. Matematiksel istatistiklere ilişkin çıkarımlar, rastgele olguların analiziyle ilgilenen olasılık teorisi çerçevesinde yapılır. ⓘ

Standart bir istatistiksel prosedür, iki istatistiksel veri seti veya bir veri seti ile idealleştirilmiş bir modelden alınan sentetik veriler arasındaki ilişkinin test edilmesine yol açan verilerin toplanmasını içerir. İki veri seti arasındaki istatistiksel ilişki için bir hipotez öne sürülür ve bu hipotez, iki veri seti arasında ilişki olmadığına dair idealize edilmiş bir boş hipoteze alternatif olarak karşılaştırılır. Sıfır hipotezinin reddedilmesi veya çürütülmesi, testte kullanılan veriler göz önüne alındığında, sıfırın yanlış olduğunun kanıtlanabileceği anlamı ölçen istatistiksel testler kullanılarak yapılır. Bir sıfır hipotezinden hareketle, iki temel hata biçimi kabul edilir: Tip I hatalar (sıfır hipotezi yanlışlıkla reddedilir ve "yanlış pozitif" sonuç verir) ve Tip II hatalar (sıfır hipotezi reddedilemez ve popülasyonlar arasındaki gerçek bir ilişki gözden kaçar ve "yanlış negatif" sonuç verir). Yeterli örneklem büyüklüğünün elde edilmesinden uygun bir sıfır hipotezinin belirlenmesine kadar birçok sorun bu çerçeveyle ilişkilendirilmektedir. ⓘ

İstatistiksel veri üreten ölçüm süreçleri de hataya tabidir. Bu hataların çoğu rastgele (gürültü) veya sistematik (yanlılık) olarak sınıflandırılır, ancak diğer hata türleri de (örneğin, bir analistin yanlış birimleri rapor etmesi gibi gaflar) ortaya çıkabilir. Kayıp verilerin varlığı veya sansürleme yanlı tahminlere neden olabilir ve bu sorunları ele almak için özel teknikler geliştirilmiştir. ⓘ

İstatistik veya sayıtım, belirli bir amaç için veri toplama, tablo ve grafiklerle özetleme, sonuçları yorumlama, sonuçların güven derecelerini açıklama, örneklerden elde edilen sonuçları kitle için genelleme, özellikler arasındaki ilişkiyi araştırma, çeşitli konularda geleceğe ilişkin tahmin yapma, deney düzenleme ve gözlem ilkelerini kapsayan bir bilimdir. Belirli bir amaç için verilerin toplanması, sınıflandırılması, çözümlenmesi ve sonuçlarının yorumlanması esasına dayanır. ⓘ

İstatistik doğa bilimlerinden sosyal bilimlere kadar geniş bir alanda uygulanabilmektedir. Aynı zamanda iş dünyası ve hükûmetle ilişkili tüm alanlarda karar almak amacıyla kullanılır. İstatistik yukarıdaki anlamıyla tekildir. Sözcüğün çoğul anlamı, "sistemli bir şekilde toplanan sayısal bilgiler"dir. Örnek olarak nüfus istatistikleri, çevre istatistikleri, spor istatistikleri, millî eğitim istatistikleri verilebilir. ⓘ

İstatistiği öğrenmedeki amaç, bir araştırmada, elde edilen verilerin hangi istatistiksel yöntemler kullanılarak yorumlanacağını bilmektir. ⓘ

İstatistiksel yöntemler, toplanmış verilerin özetlenmesi veya açıklanması amacıyla kullanılır. Bu tür bir yaklaşım betimsel istatistik adını alır. Buna ek olarak verilerdeki örtüşmelerin (kalıplar veya örüntüler), gözlemlerdeki rassallığı ve belirsizliği göze alacak şekilde, üzerinde çalışılan anakütle veya süreç hakkında sonuç çıkarma amacıyla modellenmesi, çıkarımsal istatistik adını alır. Hem betimsel istatistik hem de tahminsel istatistik, uygulamalı istatistiğin parçaları olarak sayılabilir. Matematiksel istatistik adı verilen disiplin ise konunun teorik matematiksel altyapısını inceleyen disiplindir. ⓘ

İstatistiğin diğer bölümlerle olan ilişkilerinden doğan kavramlar şu şekilde gösterilebilir: Ekonomi+İstatistik = Ekonometri, Psikoloji+İstatistik = Psikometri , Tıp+İstatistik = Biyoistatistik , Sosyoloji+İstatistik = Sosyometri, Tarih+İstatistik=Kliometri. ⓘ

Giriş

İstatistik, verilerin toplanması, analizi, yorumlanması veya açıklanması ve sunulması ile ilgili matematiksel bir bilim dalı veya matematiğin bir dalıdır. Bazıları istatistiği matematiğin bir dalı olmaktan ziyade ayrı bir matematik bilimi olarak görmektedir. Birçok bilimsel araştırma verileri kullanırken, istatistik belirsizlik bağlamında verilerin kullanımı ve belirsizlik karşısında karar verme ile ilgilidir. ⓘ

Bir probleme istatistik uygularken, çalışılacak bir popülasyon veya süreçle başlamak yaygın bir uygulamadır. Popülasyonlar, "bir ülkede yaşayan tüm insanlar" veya "bir kristali oluşturan her atom" gibi çeşitli konular olabilir. İdeal olarak, istatistikçiler tüm nüfus hakkında veri derler (nüfus sayımı adı verilen bir işlem). Bu, devlet istatistik enstitüleri tarafından organize edilebilir. Nüfus verilerini özetlemek için tanımlayıcı istatistikler kullanılabilir. Sayısal tanımlayıcılar, sürekli veriler (gelir gibi) için ortalama ve standart sapmayı içerirken, frekans ve yüzde kategorik verileri (eğitim gibi) tanımlamak açısından daha kullanışlıdır. ⓘ

Nüfus sayımı mümkün olmadığında, nüfusun örneklem adı verilen seçilmiş bir alt kümesi üzerinde çalışılır. Nüfusu temsil eden bir örneklem belirlendikten sonra, gözlemsel veya deneysel bir ortamda örneklem üyeleri için veri toplanır. Örneklem verilerini özetlemek için yine tanımlayıcı istatistikler kullanılabilir. Ancak örneklemin oluşturulması bir rastgelelik unsuru içerir; dolayısıyla örneklemden elde edilen sayısal tanımlayıcılar da belirsizliğe açıktır. Tüm popülasyon hakkında anlamlı sonuçlar çıkarmak için çıkarımsal istatistiklere ihtiyaç vardır. Rastgeleliği hesaba katarken temsil edilen popülasyon hakkında çıkarımlar yapmak için örnek verilerdeki örüntüleri kullanır. Bu çıkarımlar, verilerle ilgili evet/hayır sorularını yanıtlama (hipotez testi), verilerin sayısal özelliklerini tahmin etme (tahmin), verilerdeki ilişkileri tanımlama (korelasyon) ve verilerdeki ilişkileri modelleme (örneğin, regresyon analizi kullanarak) şeklinde olabilir. Çıkarım, çalışılan popülasyondaki veya popülasyonla ilişkili gözlemlenmemiş değerlerin tahminini, öngörüsünü ve tahminini kapsayabilir. Zaman serileri veya mekansal verilerin ekstrapolasyonu ve interpolasyonu ve veri madenciliğini içerebilir. ⓘ

Matematiksel istatistik

Matematiksel istatistik, matematiğin istatistiğe uygulanmasıdır. Bunun için kullanılan matematiksel teknikler arasında matematiksel analiz, doğrusal cebir, stokastik analiz, diferansiyel denklemler ve ölçüm teorik olasılık teorisi yer alır. ⓘ

Tarihçe

İstatistiksel çıkarım üzerine ilk yazılar, 8. ve 13. yüzyıllar arasındaki İslam Altın Çağı'nda Arap matematikçilere ve kriptograflara kadar uzanmaktadır. Al-Khalil (717-786), permütasyon ve kombinasyonların ilk kullanımını içeren Kriptografik Mesajlar Kitabı'nı, sesli ve sessiz tüm olası Arapça kelimeleri listelemek için yazmıştır. El-Kindi, Şifreli Mesajların Deşifresi Üzerine El Yazması adlı kitabında, şifreli mesajları çözmek için frekans analizinin nasıl kullanılacağına dair ayrıntılı bir açıklama yapmıştır. El Kindi aynı zamanda istatistiksel çıkarımın bilinen en eski kullanımını gerçekleştirmiş, kendisi ve daha sonraki Arap kriptograflar şifreli mesajların çözülmesi için ilk istatistiksel yöntemleri geliştirmişlerdir. İbn Adlan (1187-1268) daha sonra frekans analizinde örneklem büyüklüğünün kullanımı konusunda önemli bir katkıda bulunmuştur. ⓘ

İstatistik üzerine Avrupa'daki en eski yazılar 1663 yılında John Graunt'un Ölüm Oranları Üzerine Doğal ve Siyasi Gözlemler adlı kitabının yayınlanmasıyla başlar. İstatistiksel düşüncenin ilk uygulamaları, devletlerin politikalarını demografik ve ekonomik verilere dayandırma ihtiyaçları etrafında dönmüştür, dolayısıyla istatistik etimolojisi de buradan gelmektedir. İstatistik disiplininin kapsamı 19. yüzyılın başlarında genel olarak veri toplama ve analizini içerecek şekilde genişlemiştir. Günümüzde istatistik; devlet, iş dünyası, doğa ve sosyal bilimler alanlarında yaygın olarak kullanılmaktadır. ⓘ

Modern istatistiğin matematiksel temelleri 17. yüzyılda Gerolamo Cardano, Blaise Pascal ve Pierre de Fermat tarafından olasılık teorisinin geliştirilmesiyle atılmıştır. Matematiksel olasılık teorisi şans oyunlarının incelenmesinden doğmuştur, ancak olasılık kavramı ortaçağ hukukunda ve Juan Caramuel gibi filozoflar tarafından zaten incelenmiştir. En küçük kareler yöntemi ilk olarak 1805 yılında Adrien-Marie Legendre tarafından tanımlanmıştır. ⓘ

Modern istatistik alanı 19. yüzyılın sonlarında ve 20. yüzyılın başlarında üç aşamada ortaya çıkmıştır. Yüzyılın başındaki ilk dalga, istatistiği sadece bilimde değil, endüstri ve politikada da analiz için kullanılan titiz bir matematiksel disipline dönüştüren Francis Galton ve Karl Pearson'ın çalışmaları tarafından yönetildi. Galton'un katkıları arasında standart sapma, korelasyon, regresyon analizi kavramlarının ortaya atılması ve bu yöntemlerin boy, kilo, kirpik uzunluğu gibi çeşitli insan özelliklerinin incelenmesine uygulanması yer almaktadır. Pearson, diğer pek çok şeyin yanı sıra, çarpım momenti olarak tanımlanan Pearson çarpım momenti korelasyon katsayısını, dağılımların örneklere uydurulması için momentler yöntemini ve Pearson dağılımını geliştirmiştir. Galton ve Pearson, ilk matematiksel istatistik ve biyoistatistik (o zamanlar biyometri olarak adlandırılıyordu) dergisi olarak Biometrika'yı kurdu ve ikincisi University College London'da dünyanın ilk üniversite istatistik bölümünü kurdu. ⓘ

Ronald Fisher, Lady Tasting çay deneyi sırasında "deney sırasında hiçbir zaman kanıtlanmayan veya kurulmayan, ancak muhtemelen çürütülen" boş hipotez terimini icat etti. ⓘ

1910'lu ve 20'li yılların ikinci dalgası William Sealy Gosset tarafından başlatılmış ve dünyanın dört bir yanındaki üniversitelerde akademik disiplini tanımlayacak ders kitaplarını yazan Ronald Fisher'in içgörüleriyle doruk noktasına ulaşmıştır. Fisher'in en önemli yayınları, 1918 tarihli Mendel Kalıtımı Varsayımına Göre Akrabalar Arasındaki Korelasyon (istatistiksel terim olan varyansın ilk kez kullanıldığı çalışma), 1925 tarihli klasik çalışması Araştırmacılar için İstatistiksel Yöntemler ve 1935 tarihli Deney Tasarımı (The Design of Experiments) adlı titiz deney tasarımı modelleri geliştirdiği çalışmasıdır. Yeterlilik, yardımcı istatistikler, Fisher'in doğrusal ayırıcısı ve Fisher bilgisi kavramlarını ortaya atmıştır. 1930 tarihli The Genetical Theory of Natural Selection (Doğal Seçilimin Genetik Teorisi) adlı kitabında, istatistiği Fisher ilkesi (A. W. F. Edwards'ın "muhtemelen evrimsel biyolojideki en ünlü argüman" olarak adlandırdığı) ve cinsel seçilimde evrimde bulunan pozitif geri besleme kaçak etkisiyle ilgili bir kavram olan Fisherian kaçak gibi çeşitli biyolojik kavramlara uyguladı. ⓘ

Esas olarak daha önceki gelişmelerin iyileştirilmesi ve genişletilmesine tanık olan son dalga, 1930'larda Egon Pearson ve Jerzy Neyman arasındaki ortak çalışmadan ortaya çıkmıştır. "Tip II" hata, bir testin gücü ve güven aralıkları kavramlarını ortaya attılar. Jerzy Neyman 1934 yılında tabakalı rastgele örneklemenin genel olarak amaçlı (kota) örneklemeden daha iyi bir tahmin yöntemi olduğunu göstermiştir. ⓘ

Günümüzde istatistiksel yöntemler, karar vermeyi içeren tüm alanlarda, harmanlanmış bir veri bütününden doğru çıkarımlar yapmak ve istatistiksel metodolojiye dayalı belirsizlik karşısında karar vermek için uygulanmaktadır. Modern bilgisayarların kullanımı büyük ölçekli istatistiksel hesaplamaları hızlandırmış ve manuel olarak gerçekleştirilmesi pratik olmayan yeni yöntemleri de mümkün kılmıştır. İstatistik, örneğin büyük verilerin nasıl analiz edileceği konusunda aktif bir araştırma alanı olmaya devam etmektedir. ⓘ

İstatistiksel veri

Veri toplama

Örnekleme

Tam nüfus sayımı verileri toplanamadığında, istatistikçiler özel deney tasarımları ve anket örnekleri geliştirerek örnek veriler toplar. İstatistiğin kendisi de istatistiksel modeller aracılığıyla tahmin ve öngörü için araçlar sağlar. ⓘ

Bir örneklemi tüm nüfusa rehber olarak kullanmak için, örneklemin nüfusun genelini gerçekten temsil etmesi önemlidir. Temsili örnekleme, çıkarımların ve sonuçların örneklemden bir bütün olarak popülasyona güvenli bir şekilde yayılabilmesini sağlar. Önemli bir sorun, seçilen örneklemin gerçekten ne ölçüde temsili olduğunun belirlenmesinde yatmaktadır. İstatistik, örneklem ve veri toplama prosedürlerindeki herhangi bir önyargıyı tahmin etmek ve düzeltmek için yöntemler sunar. Ayrıca, bir çalışmanın başlangıcında bu sorunları azaltabilecek ve popülasyon hakkındaki gerçekleri ayırt etme kapasitesini güçlendirebilecek deneyler için deneysel tasarım yöntemleri de vardır. ⓘ

Örnekleme teorisi, matematiksel olasılık teorisi disiplininin bir parçasıdır. Olasılık, matematiksel istatistikte örneklem istatistiklerinin örnekleme dağılımlarını ve daha genel olarak istatistiksel prosedürlerin özelliklerini incelemek için kullanılır. Herhangi bir istatistiksel yöntemin kullanımı, söz konusu sistem veya popülasyon yöntemin varsayımlarını karşıladığında geçerlidir. Klasik olasılık teorisi ile örnekleme teorisi arasındaki bakış açısı farkı, kabaca, olasılık teorisinin örneklere ilişkin olasılıkları çıkarmak için toplam bir popülasyonun verilen parametrelerinden başlamasıdır. İstatistiksel çıkarım ise tam tersi yönde hareket eder; örneklerden daha büyük veya toplam bir popülasyonun parametrelerine doğru tümevarımsal olarak çıkarım yapar. ⓘ

Deneysel ve gözlemsel çalışmalar

İstatistiksel bir araştırma projesinin ortak amacı nedenselliği araştırmak ve özellikle tahmin edicilerin veya bağımsız değişkenlerin değerlerindeki değişikliklerin bağımlı değişkenler üzerindeki etkisi hakkında bir sonuca varmaktır. Başlıca iki tür nedensel istatistiksel çalışma vardır: deneysel çalışmalar ve gözlemsel çalışmalar. Her iki çalışma türünde de bağımsız değişken (veya değişkenler) arasındaki farklılıkların bağımlı değişkenin davranışı üzerindeki etkisi gözlemlenir. İki tür arasındaki fark, çalışmanın gerçekte nasıl yürütüldüğünde yatmaktadır. Her ikisi de çok etkili olabilir. Deneysel bir çalışma, incelenen sistemin ölçümlerini almayı, sistemi manipüle etmeyi ve ardından manipülasyonun ölçümlerin değerlerini değiştirip değiştirmediğini belirlemek için aynı prosedürü kullanarak ek ölçümler almayı içerir. Buna karşılık, gözlemsel bir çalışma deneysel manipülasyon içermez. Bunun yerine, veriler toplanır ve tahmin ediciler ile yanıt arasındaki korelasyonlar araştırılır. Veri analizi araçları en iyi rastgele çalışmalardan elde edilen veriler üzerinde çalışsa da, bir istatistikçinin tutarlı tahminciler üreten değiştirilmiş, daha yapılandırılmış bir tahmin yöntemi (örneğin, diğerlerinin yanı sıra farklılıklardaki fark tahmini ve araçsal değişkenler) kullanacağı doğal deneyler ve gözlemsel çalışmalar gibi diğer veri türlerine de uygulanır. ⓘ

Deneyler

İstatistiksel bir deneyin temel adımları şunlardır:

- Aşağıdaki bilgileri kullanarak çalışmanın tekrar sayısını bulmak da dahil olmak üzere araştırmanın planlanması: tedavi etkilerinin boyutuna ilişkin ön tahminler, alternatif hipotezler ve tahmini deneysel değişkenlik. Deneysel deneklerin seçimi ve araştırma etiğinin göz önünde bulundurulması gereklidir. İstatistikçiler, tedavi etkilerindeki farkın tarafsız bir şekilde tahmin edilebilmesi için deneylerin (en az) bir yeni tedaviyi standart bir tedavi veya kontrol ile karşılaştırmasını tavsiye etmektedir.

- Karıştırıcı değişkenlerin etkisini azaltmak için bloklama kullanarak deneylerin tasarlanması ve tedavi etkilerinin ve deneysel hatanın tarafsız tahminlerine izin vermek için tedavilerin deneklere rastgele atanması. Bu aşamada, deneyciler ve istatistikçiler, deneyin performansına rehberlik edecek ve deneysel verilerin birincil analizini belirleyen deney protokolünü yazarlar.

- Deneysel protokolü takiben deneyin gerçekleştirilmesi ve deneysel protokolü takiben verilerin analiz edilmesi.

- Gelecekteki çalışmalar için yeni hipotezler önermek üzere ikincil analizlerde veri setinin daha fazla incelenmesi.

- Çalışmanın sonuçlarının belgelenmesi ve sunulması. ⓘ

İnsan davranışı üzerine yapılan deneylerin özel kaygıları vardır. Ünlü Hawthorne çalışması, Western Electric Company'nin Hawthorne fabrikasındaki çalışma ortamında yapılan değişiklikleri incelemiştir. Araştırmacılar, artan aydınlatmanın montaj hattı işçilerinin verimliliğini artırıp artırmayacağını belirlemekle ilgileniyorlardı. Araştırmacılar önce fabrikadaki verimliliği ölçtüler, ardından fabrikanın bir bölgesindeki aydınlatmayı değiştirdiler ve aydınlatmadaki değişikliklerin verimliliği etkileyip etkilemediğini kontrol ettiler. Verimliliğin gerçekten de (deneysel koşullar altında) arttığı ortaya çıktı. Ancak çalışma bugün deneysel prosedürlerdeki hatalar, özellikle de kontrol grubunun olmaması ve körlük nedeniyle ağır bir şekilde eleştirilmektedir. Hawthorne etkisi, bir sonucun (bu durumda işçi verimliliği) gözlemin kendisi nedeniyle değiştiğini bulmayı ifade eder. Hawthorne çalışmasındaki kişiler, aydınlatma değiştirildiği için değil, gözlemlendikleri için daha üretken hale gelmişlerdir. ⓘ

Gözlemsel çalışma

Gözlemsel bir çalışmaya örnek olarak sigara ve akciğer kanseri arasındaki ilişkiyi araştıran bir çalışma verilebilir. Bu tür bir çalışma tipik olarak ilgilenilen alanla ilgili gözlemleri toplamak için bir anket kullanır ve ardından istatistiksel analiz gerçekleştirir. Bu durumda araştırmacılar, belki de bir kohort çalışması yoluyla hem sigara içen hem de içmeyenlerin gözlemlerini toplayacak ve ardından her gruptaki akciğer kanseri vakalarının sayısını araştıracaktır. Vaka kontrol çalışması, ilgilenilen sonuca (örneğin akciğer kanseri) sahip olan ve olmayan kişilerin katılmaya davet edildiği ve maruziyet geçmişlerinin toplandığı bir başka gözlemsel çalışma türüdür. ⓘ

Veri türleri

Ölçüm seviyelerinin bir taksonomisini oluşturmak için çeşitli girişimlerde bulunulmuştur. Psikofizikçi Stanley Smith Stevens nominal, ordinal, aralık ve oran ölçeklerini tanımlamıştır. Nominal ölçümler değerler arasında anlamlı bir sıralamaya sahip değildir ve herhangi bir bire-bir (enjektif) dönüşüme izin verir. Sıralı ölçümler, ardışık değerler arasında kesin olmayan farklara sahiptir, ancak bu değerler için anlamlı bir sıraya sahiptir ve herhangi bir sırayı koruyan dönüşüme izin verir. Aralık ölçümleri tanımlanmış ölçümler arasında anlamlı mesafelere sahiptir, ancak sıfır değeri keyfidir (Celsius veya Fahrenheit cinsinden boylam ve sıcaklık ölçümlerinde olduğu gibi) ve herhangi bir doğrusal dönüşüme izin verir. Oran ölçümleri hem anlamlı bir sıfır değerine hem de tanımlanmış farklı ölçümler arasındaki mesafelere sahiptir ve her türlü yeniden ölçeklendirme dönüşümüne izin verir. ⓘ

Yalnızca nominal veya sıralı ölçümlere uyan değişkenler sayısal olarak makul bir şekilde ölçülemediğinden, bazen kategorik değişkenler olarak gruplandırılırken, oran ve aralık ölçümleri sayısal yapıları nedeniyle kesikli veya sürekli olabilen nicel değişkenler olarak gruplandırılır. Bu tür ayrımlar genellikle bilgisayar bilimlerindeki veri tipiyle gevşek bir şekilde ilişkilendirilebilir; zira ikili kategorik değişkenler Boolean veri tipiyle, çoklu kategorik değişkenler integral veri tipinde keyfi olarak atanmış tam sayılarla ve sürekli değişkenler kayan noktalı aritmetik içeren gerçek veri tipiyle temsil edilebilir. Ancak bilgisayar bilimleri veri türlerinin istatistiksel veri türleriyle eşleştirilmesi, hangi kategorizasyonun uygulandığına bağlıdır. ⓘ

Başka kategorizasyonlar da önerilmiştir. Örneğin, Mosteller ve Tukey (1977) notları, sıraları, sayılan kesirleri, sayıları, miktarları ve bakiyeleri birbirinden ayırmıştır. Nelder (1990) sürekli sayımları, sürekli oranları, sayım oranlarını ve kategorik veri modlarını tanımlamıştır. (Ayrıca bkz: Chrisman (1998), van den Berg (1991)). ⓘ

Farklı ölçüm prosedürlerinden elde edilen verilere farklı türde istatistiksel yöntemlerin uygulanmasının uygun olup olmadığı konusu, değişkenlerin dönüştürülmesi ve araştırma sorularının kesin olarak yorumlanmasıyla ilgili konular nedeniyle karmaşıktır. "Veriler ve tanımladıkları şey arasındaki ilişki, yalnızca belirli türdeki istatistiksel ifadelerin bazı dönüşümler altında değişmez olmayan doğruluk değerlerine sahip olabileceği gerçeğini yansıtır. Bir dönüşümü düşünmenin mantıklı olup olmadığı, kişinin yanıtlamaya çalıştığı soruya bağlıdır." ⓘ

Yöntemler

Tanımlayıcı istatistikler

Tanımlayıcı istatistik (sayma ismi anlamında), bir bilgi koleksiyonunun özelliklerini niceliksel olarak tanımlayan veya özetleyen özet bir istatistiktir; toplu isim anlamında tanımlayıcı istatistik ise bu istatistikleri kullanma ve analiz etme sürecidir. Tanımlayıcı istatistikler, çıkarımsal istatistiklerden (veya tümevarımsal istatistiklerden) ayrılır; çünkü tanımlayıcı istatistikler, veri örneğinin temsil ettiği düşünülen popülasyon hakkında bilgi edinmek için verileri kullanmak yerine bir örneği özetlemeyi amaçlar. ⓘ

Çıkarımsal istatistik

İstatistiksel çıkarım, altta yatan bir olasılık dağılımının özelliklerini çıkarmak için veri analizini kullanma sürecidir. Çıkarımsal istatistiksel analiz, örneğin hipotezleri test ederek ve tahminler türeterek bir popülasyonun özelliklerini çıkarır. Gözlenen veri setinin daha büyük bir popülasyondan örneklendiği varsayılır. Çıkarımsal istatistik, tanımlayıcı istatistik ile karşılaştırılabilir. Tanımlayıcı istatistikler yalnızca gözlemlenen verilerin özellikleriyle ilgilenir ve verilerin daha büyük bir popülasyondan geldiği varsayımına dayanmaz. ⓘ

Çıkarımsal istatistik terminolojisi ve teorisi

İstatistikler, tahmin ediciler ve önemli büyüklükler

Belirli bir olasılık dağılımına sahip bağımsız özdeş dağılımlı (IID) rastgele değişkenler düşünün: standart istatistiksel çıkarım ve tahmin teorisi, rastgele bir örneği bu IID değişkenlerinin sütun vektörü tarafından verilen rastgele vektör olarak tanımlar. İncelenen popülasyon, bilinmeyen parametrelere sahip olabilen bir olasılık dağılımı ile tanımlanır. ⓘ

İstatistik, rastgele örneklemin bir fonksiyonu olan rastgele bir değişkendir, ancak bilinmeyen parametrelerin bir fonksiyonu değildir. Bununla birlikte, istatistiğin olasılık dağılımı bilinmeyen parametrelere sahip olabilir. Şimdi bilinmeyen parametrenin bir fonksiyonunu düşünün: bir tahmin edici, bu fonksiyonu tahmin etmek için kullanılan bir istatistiktir. Yaygın olarak kullanılan tahmin ediciler arasında örneklem ortalaması, yansız örneklem varyansı ve örneklem kovaryansı yer alır. ⓘ

Rastgele örneklemin ve bilinmeyen parametrenin bir fonksiyonu olan, ancak olasılık dağılımı bilinmeyen parametreye bağlı olmayan rastgele bir değişkene pivotal miktar veya pivot denir. Yaygın olarak kullanılan pivotlar arasında z-skoru, ki kare istatistiği ve Student'ın t-değeri bulunur. ⓘ

Belirli bir parametrenin iki tahmin edicisi arasında, daha düşük ortalama karesel hataya sahip olanın daha verimli olduğu söylenir. Ayrıca, bir tahmin edicinin beklenen değeri tahmin edilen bilinmeyen parametrenin gerçek değerine eşitse yansız olduğu ve beklenen değeri limitte söz konusu parametrenin gerçek değerine yakınsıyorsa asimptotik olarak yansız olduğu söylenir. ⓘ

Tahmin ediciler için istenen diğer özellikler şunlardır: Tahmin edilecek parametrenin tüm olası değerleri için en düşük varyansa sahip UMVUE tahmin edicileri (bu genellikle doğrulanması verimlilikten daha kolay bir özelliktir) ve olasılıkla söz konusu parametrenin gerçek değerine yakınsayan tutarlı tahmin ediciler. ⓘ

Bu durum hala belirli bir durumda tahmin edicilerin nasıl elde edileceği ve hesaplamanın nasıl yapılacağı sorusunu ortaya çıkarmaktadır; bu konuda çeşitli yöntemler önerilmiştir: momentler yöntemi, maksimum olabilirlik yöntemi, en küçük kareler yöntemi ve daha yeni bir yöntem olan denklem tahmin yöntemi. ⓘ

Boş hipotez ve alternatif hipotez

İstatistiksel bilgilerin yorumlanması genellikle (zorunlu olmamakla birlikte) değişkenler arasında herhangi bir ilişki bulunmadığı veya zaman içinde herhangi bir değişiklik meydana gelmediği şeklinde bir sıfır hipotezinin geliştirilmesini içerebilir. ⓘ

Bir acemi için en iyi örnek, bir ceza davasında karşılaşılan çıkmazdır. Sıfır hipotezi, H0, sanığın masum olduğunu iddia ederken, alternatif hipotez, H1, sanığın suçlu olduğunu iddia eder. İddianame suç şüphesi nedeniyle hazırlanmıştır. H0 (statüko), H1'in karşısında durur ve H1 "makul şüphenin ötesinde" kanıtlarla desteklenmedikçe korunur. Ancak, bu durumda "H0'ın reddedilmemesi" masumiyet anlamına gelmez, yalnızca kanıtların mahkumiyet için yetersiz olduğu anlamına gelir. Yani jüri H0'ı kabul etmek zorunda değildir ancak H0'ı reddedemez. Bir boş hipotezi "kanıtlamak" mümkün olmasa da, tip II hataları test eden bir güç testi ile doğruya ne kadar yakın olduğu test edilebilir. ⓘ

İstatistikçilerin alternatif hipotez dedikleri şey, basitçe sıfır hipoteziyle çelişen bir hipotezdir. ⓘ

Hata

Bir sıfır hipotezinden hareketle, iki geniş hata kategorisi kabul edilmektedir:

- Sıfır hipotezinin yanlışlıkla reddedildiği ve "yanlış pozitif" sonuç veren Tip I hatalar.

- Sıfır hipotezinin reddedilemediği ve popülasyonlar arasındaki gerçek bir farkın gözden kaçırıldığı, "yanlış negatif" veren Tip II hatalar. ⓘ

Standart sapma, bir örneklemdeki bireysel gözlemlerin örneklem veya popülasyon ortalaması gibi merkezi bir değerden ne ölçüde farklı olduğunu ifade ederken Standart hata, örneklem ortalaması ile popülasyon ortalaması arasındaki farkın bir tahminini ifade eder. ⓘ

İstatistiksel hata, bir gözlemin beklenen değerinden farklı olduğu miktardır. Artık, bir gözlemin, beklenen değerin tahmin edicisinin belirli bir örneklem üzerinde varsaydığı değerden farklı olan miktarıdır (tahmin olarak da adlandırılır). ⓘ

Ortalama karesel hata, yaygın olarak kullanılan bir tahminci sınıfı olan etkin tahmincileri elde etmek için kullanılır. Ortalama karesel hatanın kökü, basitçe ortalama karesel hatanın kareköküdür. ⓘ

Birçok istatistiksel yöntem artık kareler toplamını en aza indirmeye çalışır ve bunlara En küçük mutlak sapmaların aksine "en küçük kareler yöntemleri" denir. İkincisi küçük ve büyük hatalara eşit ağırlık verirken, ilki büyük hatalara daha fazla ağırlık verir. Artık kareler toplamı da türevlenebilirdir, bu da regresyon yapmak için kullanışlı bir özellik sağlar. Doğrusal regresyona uygulanan en küçük kareler sıradan en küçük kareler yöntemi olarak adlandırılırken, doğrusal olmayan regresyona uygulanan en küçük kareler doğrusal olmayan en küçük kareler olarak adlandırılır. Ayrıca doğrusal bir regresyon modelinde modelin deterministik olmayan kısmına hata terimi, bozulma veya daha basitçe gürültü denir. Hem doğrusal regresyon hem de doğrusal olmayan regresyon, bağımsız değişkenin (x ekseni) bir fonksiyonu olarak bağımlı değişkenin (y ekseni) tahminindeki varyansı ve tahmin edilen (uydurulan) eğriden sapmaları (hatalar, gürültü, bozulmalar) da tanımlayan polinom en küçük karelerde ele alınır. ⓘ

İstatistiksel veri üreten ölçüm süreçleri de hataya tabidir. Bu hataların çoğu rastgele (gürültü) veya sistematik (yanlılık) olarak sınıflandırılır, ancak diğer hata türleri de (örneğin, bir analistin yanlış birimleri rapor etmesi gibi gaflar) önemli olabilir. Kayıp verilerin varlığı veya sansürleme yanlı tahminlere neden olabilir ve bu sorunları ele almak için özel teknikler geliştirilmiştir. ⓘ

Aralık tahmini

Çoğu çalışma bir popülasyonun yalnızca bir kısmını örneklemektedir, bu nedenle sonuçlar tüm popülasyonu tam olarak temsil etmemektedir. Örneklemden elde edilen tahminler yalnızca popülasyon değerine yaklaşır. Güven aralıkları, istatistikçilerin örneklem tahmininin tüm popülasyondaki gerçek değere ne kadar yakın olduğunu ifade etmelerini sağlar. Genellikle %95 güven aralıkları olarak ifade edilirler. Resmi olarak, bir değer için %95 güven aralığı, örnekleme ve analiz aynı koşullar altında tekrarlanırsa (farklı bir veri kümesi elde edilirse), aralığın tüm olası durumların %95'inde gerçek (popülasyon) değeri içereceği bir aralıktır. Bu, gerçek değerin güven aralığında olma olasılığının %95 olduğu anlamına gelmez. Sıklıkçı bakış açısına göre, gerçek değer rastgele bir değişken olmadığı için böyle bir iddia mantıklı bile değildir. Gerçek değer ya verilen aralığın içindedir ya da değildir. Bununla birlikte, herhangi bir veri örneklenmeden ve güven aralığının nasıl oluşturulacağına dair bir plan verilmeden önce, henüz hesaplanmamış aralığın gerçek değeri kapsama olasılığının %95 olduğu doğrudur: bu noktada, aralığın sınırları henüz gözlemlenmemiş rastgele değişkenlerdir. Belirli bir olasılığın gerçek değeri içerdiği şeklinde yorumlanabilecek bir aralık veren bir yaklaşım, Bayesian istatistiklerinden güvenilir bir aralık kullanmaktır: bu yaklaşım, "olasılık" ile neyin kastedildiğinin farklı bir şekilde, yani Bayesian olasılığı olarak yorumlanmasına bağlıdır. ⓘ

Prensip olarak güven aralıkları simetrik veya asimetrik olabilir. Bir aralık asimetrik olabilir çünkü bir parametre için alt veya üst sınır olarak çalışır (sol taraflı aralık veya sağ taraflı aralık), ancak aynı zamanda asimetrik olabilir çünkü iki taraflı aralık, tahmin etrafındaki simetriyi ihlal ederek oluşturulur. Bazen bir güven aralığı için sınırlara asimptotik olarak ulaşılır ve bunlar gerçek sınırlara yaklaşmak için kullanılır. ⓘ

Anlamlılık

İstatistikler analiz edilen soruya nadiren basit bir Evet/Hayır tipi cevap verir. Yorumlama genellikle sayılara uygulanan istatistiksel anlamlılık düzeyine bağlıdır ve genellikle bir değerin sıfır hipotezini doğru bir şekilde reddetme olasılığını ifade eder (bazen p-değeri olarak da adlandırılır). ⓘ

Standart yaklaşım, boş bir hipotezi alternatif bir hipoteze karşı test etmektir. Kritik bölge, sıfır hipotezinin reddedilmesine yol açan tahmin edicinin değerler kümesidir. Bu nedenle, I. tip hata olasılığı, sıfır hipotezin doğru olması durumunda tahmin edicinin kritik bölgeye ait olma olasılığıdır (istatistiksel anlamlılık) ve II. tip hata olasılığı, alternatif hipotezin doğru olması durumunda tahmin edicinin kritik bölgeye ait olmama olasılığıdır. Bir testin istatistiksel gücü, boş hipotez yanlış olduğunda boş hipotezi doğru bir şekilde reddetme olasılığıdır. ⓘ

İstatistiksel anlamlılığa atıfta bulunmak, genel sonucun gerçek dünya şartlarında anlamlı olduğu anlamına gelmez. Örneğin, bir ilaç üzerinde yapılan büyük bir çalışmada, ilacın istatistiksel olarak anlamlı ancak çok küçük bir yararlı etkiye sahip olduğu gösterilebilir, öyle ki ilacın hastaya belirgin bir şekilde yardımcı olma olasılığı düşüktür. ⓘ

Prensipte kabul edilebilir istatistiksel anlamlılık düzeyi tartışmaya açık olsa da, anlamlılık düzeyi, testin sıfır hipotezini reddetmesini sağlayan en büyük p-değeridir. Bu test mantıksal olarak, p-değerinin, sıfır hipotezinin doğru olduğu varsayıldığında, en az test istatistiği kadar uç bir sonuç gözlemleme olasılığı olduğunu söylemeye eşdeğerdir. Dolayısıyla, anlamlılık düzeyi ne kadar küçük olursa, I. tip hata yapma olasılığı da o kadar düşük olur. ⓘ

Bu çerçeveyle genellikle bazı sorunlar ilişkilendirilir (Bkz. Hipotez testinin eleştirisi):

- İstatistiksel olarak son derece anlamlı olan bir fark yine de pratik bir öneme sahip olmayabilir, ancak bunu hesaba katmak için testleri uygun şekilde formüle etmek mümkündür. Bir yanıt, bir hipotezin reddedildiğini veya kabul edildiğini bildirirken yalnızca anlamlılık düzeyini bildirmenin ötesine geçerek p-değerini de dahil etmeyi içerir. Ancak p-değeri, gözlemlenen etkinin büyüklüğünü veya önemini göstermez ve ayrıca büyük çalışmalarda küçük farklılıkların önemini abartıyor gibi görünebilir. Daha iyi ve giderek yaygınlaşan bir yaklaşım ise güven aralıklarını raporlamaktır. Bunlar hipotez testleri veya p-değerleri ile aynı hesaplamalardan elde edilse de, hem etkinin boyutunu hem de onu çevreleyen belirsizliği tanımlamaktadır.

- Yer değiştirmiş koşullu yanılgısı, diğer adıyla savcı yanılgısı: eleştiriler, hipotez testi yaklaşımının bir hipotezi (boş hipotez) tercih etmeye zorlaması nedeniyle ortaya çıkmaktadır, çünkü değerlendirilen şey boş hipotez göz önüne alındığında gözlenen sonucun olasılığıdır, gözlenen sonuç göz önüne alındığında boş hipotezin olasılığı değildir. Bu yaklaşıma bir alternatif olarak Bayesçi çıkarım sunulmaktadır, ancak bu da bir ön olasılık belirlenmesini gerektirmektedir.

- Sıfır hipotezinin reddedilmesi alternatif hipotezi otomatik olarak kanıtlamaz.

- Çıkarımsal istatistikteki her şey gibi örneklem büyüklüğüne dayanır ve bu nedenle büyük kuyruklar altında p-değerleri ciddi şekilde yanlış hesaplanabilir. ⓘ

Örnekler

Bazı iyi bilinen istatistiksel testler ve prosedürler şunlardır:

- Varyans analizi (ANOVA)

- Ki-kare testi

- Korelasyon

- Faktör analizi

- Mann-Whitney U

- Ortalama kare ağırlıklı sapma (MSWD)

- Pearson Momentler Çarpımı Korelasyon Katsayısı

- Regresyon analizi

- Spearman'ın sıra korelasyon katsayısı

- Öğrenci t-testi

- Zaman serisi analizi

- Konjoint Analizi ⓘ

Keşifsel veri analizi

Keşifsel veri analizi (KVA), temel özelliklerini özetlemek için veri setlerini genellikle görsel yöntemlerle analiz etmeye yönelik bir yaklaşımdır. İstatistiksel bir model kullanılabilir ya da kullanılmayabilir, ancak öncelikle EDA, resmi modelleme veya hipotez testi görevinin ötesinde verilerin bize neler söyleyebileceğini görmek içindir. ⓘ

Yanlış kullanım

İstatistiklerin yanlış kullanımı, tanımlama ve yorumlamada ince ama ciddi hatalara yol açabilir - deneyimli profesyonellerin bile bu tür hatalar yapması anlamında ince, yıkıcı karar hatalarına yol açabilmesi anlamında ise ciddi. Örneğin, sosyal politikalar, tıbbi uygulamalar ve köprü gibi yapıların güvenilirliği istatistiklerin doğru kullanımına bağlıdır. ⓘ

İstatistiksel teknikler doğru uygulandığında bile, uzmanlığı olmayan kişiler için sonuçların yorumlanması zor olabilir. Verilerdeki bir eğilimin istatistiksel önemi - bir eğilimin örneklemdeki rastgele varyasyondan ne ölçüde kaynaklanabileceğini ölçen - önemine dair sezgisel bir hisle uyuşabilir veya uyuşmayabilir. İnsanların günlük yaşamlarında bilgi ile düzgün bir şekilde başa çıkmak için ihtiyaç duydukları temel istatistiksel beceriler (ve şüphecilik) kümesi istatistiksel okuryazarlık olarak adlandırılır. ⓘ

İstatistiksel bilginin, yalnızca sunumu yapan kişinin lehine olan verileri yorumlamanın yollarını bularak sık sık kasıtlı olarak kötüye kullanıldığına dair genel bir algı vardır. İstatistiğe duyulan güvensizlik ve yanlış anlama, "Üç tür yalan vardır: yalanlar, lanetlenmiş yalanlar ve istatistikler" sözüyle ilişkilendirilir. İstatistiklerin yanlış kullanımı hem kasıtsız hem de kasıtlı olabilir ve Darrell Huff tarafından yazılan How to Lie with Statistics (İstatistiklerle Nasıl Yalan Söylenir) adlı kitap bir dizi hususu özetlemektedir. İstatistiklerin kullanımına ve kötüye kullanımına ışık tutmak amacıyla, belirli alanlarda kullanılan istatistiksel tekniklere ilişkin incelemeler yapılmaktadır (örneğin Warne, Lazo, Ramos ve Ritter (2012)). ⓘ

İstatistiğin yanlış kullanımından kaçınmanın yolları arasında uygun diyagramlar kullanmak ve önyargıdan kaçınmak yer alır. Yanlış kullanım, sonuçlar aşırı genelleştirildiğinde ve gerçekte olduğundan daha fazlasını temsil ettiği iddia edildiğinde, genellikle kasıtlı veya bilinçsiz olarak örnekleme yanlılığının göz ardı edilmesiyle ortaya çıkabilir. Çubuk grafikler muhtemelen kullanımı ve anlaşılması en kolay diyagramlardır ve elle ya da basit bilgisayar programlarıyla yapılabilir. Ne yazık ki, çoğu insan önyargı veya hata aramaz, bu yüzden fark edilmezler. Bu nedenle, insanlar genellikle iyi temsil edilmemiş olsa bile bir şeyin doğru olduğuna inanabilir. İstatistiklerden elde edilen verilerin inandırıcı ve doğru olması için, alınan örneklemin bütünü temsil etmesi gerekir. Huff'a göre, "Bir örneklemin güvenilirliği [önyargı] tarafından yok edilebilir... kendinize bir dereceye kadar şüphecilik tanıyın." ⓘ

Huff, istatistiğin anlaşılmasına yardımcı olmak için her durumda sorulması gereken bir dizi soru önermiştir:

- Kim böyle söylüyor? (Bir çıkarı mı var?)

- Nasıl biliyor? (Gerçekleri bilmek için gerekli kaynaklara sahip mi?)

- Eksik olan ne? (Bize tam bir resim sunuyor mu?)

- Birisi konuyu değiştirdi mi? (Bize yanlış soruna doğru cevabı mı sunuyor?)

- Mantıklı mı? (Vardığı sonuç mantıklı ve zaten bildiklerimizle tutarlı mı?) ⓘ

Yanlış yorumlama: korelasyon

Korelasyon kavramı, neden olabileceği potansiyel karışıklık açısından özellikle dikkat çekicidir. Bir veri setinin istatistiksel analizi, genellikle söz konusu nüfusun iki değişkeninin (özelliklerinin) sanki birbirleriyle bağlantılıymış gibi birlikte değişme eğiliminde olduğunu ortaya koyar. Örneğin, yıllık gelirin yanı sıra ölüm yaşını da inceleyen bir çalışma, yoksul insanların varlıklı insanlara göre daha kısa ömürlü olma eğiliminde olduğunu ortaya koyabilir. Bu iki değişkenin birbiriyle ilişkili olduğu söylenir; ancak bunlar birbirinin nedeni olabilir ya da olmayabilir. Korelasyon olgusuna, gizlenen değişken veya karıştırıcı değişken olarak adlandırılan, daha önce dikkate alınmamış üçüncü bir olgu neden olabilir. Bu nedenle, iki değişken arasında nedensel bir ilişkinin varlığını hemen çıkarmanın bir yolu yoktur. ⓘ

Uygulamalar

Uygulamalı istatistik, teorik istatistik ve matematiksel istatistik

Bazen İstatistik bilimi olarak da adlandırılan uygulamalı istatistik, tanımlayıcı istatistikleri ve çıkarımsal istatistiklerin uygulanmasını içerir. Teorik istatistik, istatistiksel çıkarım yaklaşımlarının gerekçelendirilmesinin altında yatan mantıksal argümanlarla ilgilidir ve matematiksel istatistiği de kapsar. Matematiksel istatistik, yalnızca tahmin ve çıkarım yöntemleriyle ilgili sonuçların elde edilmesi için gerekli olan olasılık dağılımlarının manipülasyonunu değil, aynı zamanda hesaplamalı istatistiklerin ve deney tasarımının çeşitli yönlerini de içerir. ⓘ

İstatistiksel danışmanlar, kendi sorularıyla ilgili kurum içi uzmanlığa sahip olmayan kuruluşlara ve şirketlere yardımcı olabilir. ⓘ

Makine öğrenimi ve veri madenciliği

Makine öğrenimi modelleri, hesaplama algoritmaları kullanarak verilerdeki örüntüleri yakalayan istatistiksel ve olasılıksal modellerdir. ⓘ

Akademide istatistik

İstatistik, doğal ve sosyal bilimler, devlet ve iş dünyası dahil olmak üzere çok çeşitli akademik disiplinlere uygulanabilir. İş istatistikleri, ekonometri, denetim ve hizmet iyileştirme ve pazarlama araştırmaları da dahil olmak üzere üretim ve operasyonlarda istatistiksel yöntemler uygular. Tropikal biyoloji alanındaki iki dergide yapılan bir çalışmada, en sık kullanılan 12 istatistiksel testin şunlar olduğu bulunmuştur: Varyans Analizi (ANOVA), Ki-Kare Testi, Student's T Testi, Doğrusal Regresyon, Pearson Korelasyon Katsayısı, Mann-Whitney U Testi, Kruskal-Wallis Testi, Shannon Çeşitlilik Endeksi, Tukey Testi, Küme Analizi, Spearman'ın Sıra Korelasyon Testi ve Temel Bileşen Analizi. ⓘ

Tipik bir istatistik dersi, tanımlayıcı istatistikler, olasılık, binom ve normal dağılımlar, hipotez testleri ve güven aralıkları, doğrusal regresyon ve korelasyon konularını kapsar. Lisans öğrencilerine yönelik modern temel istatistik dersleri, doğru test seçimi, sonuçların yorumlanması ve ücretsiz istatistik yazılımlarının kullanımına odaklanmaktadır. ⓘ

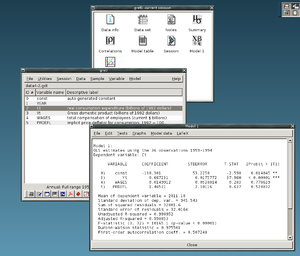

İstatistiksel hesaplama

20. yüzyılın ikinci yarısında bilgisayarların hesaplama gücü ve hızının inanılamayacak bir şekilde artması ve bilgisayar kullanımı yaygın bir hale gelmesi istatistik biliminin pratik uygulaması ve hatta teorik gelişmesi üzerine çok büyük etki yapmıştır. Pratik istatistik hesaplamanın çok zor olması dolayısıyla veri analizi devamlı olarak hesaplamanın kolaylaştırılması üzerine odaklanıp daha çok doğrusal modellere dayanmıştır. Çok yaygın kullanılan ve çok güçlü bilgisayarların kullanılmaya başlanılması ve sayısal algoritmaların geliştirilip bilgisayar yazılımları geliştirilmesi ile yeni doğrusal olmayan modeller (örneğin doğrusal olmayan regresyon, genelleştirilmiş doğrusal modeller, çok-seviyeli model gibi) pratikte kullanılmaya başlanmıştır. ⓘ

Bilgisayar devrimi tekrar örnekleme yöntemi, özyükleme yöntemleri, Gibbs örneklemesi, permütasyon testleri gibi çok bilgisayara dayanan teknikler kullanılmaya başlamıştır. Diğer taraftan istatistik gibi temeli ileri matematiğe bağlı olmayan ve büyük bilgisayar gücüne dayanan (yapay sinir ağları veya veri madenciliği gibi) araştırma ve pratik veri inceleme yöntemleri gelişmiştir. ⓘ

İstatistik biliminin geleceği 20. yüzyıl başındaki teorik gelişmelerden sonra, daha empirik ve pratik bir yaklaşım haline gelmektedir. Bu yaklaşımda genel hesaplama yazılım ve paketlere istatistik yöntemlerinin eklenmeleri (örneğin kutuzzilim programlarının istatistiksel bölümleri) ve özel şekil de hazırlanmış istatistiksel paketlerinin yaygın şekilde kullanılabilmesi büyük bir rol oynayacağı şüphesizdir. ⓘ

Artan hesaplama gücü, permütasyon testleri ve bootstrap gibi yeniden örneklemeye dayalı hesaplama açısından yoğun yöntemlerin popülerliğinin artmasına neden olurken, Gibbs örneklemesi gibi teknikler Bayes modellerinin kullanımını daha uygulanabilir hale getirmiştir. Bilgisayar devriminin, "deneysel" ve "ampirik" istatistiklere yeni bir vurgu yaparak istatistiğin geleceği üzerinde etkileri vardır. Artık hem genel hem de özel amaçlı çok sayıda istatistik yazılımı mevcuttur. Karmaşık istatistiksel hesaplama yapabilen mevcut yazılımlara örnek olarak Mathematica, SAS, SPSS ve R gibi programlar verilebilir. ⓘ

İş istatistikleri

İş dünyasında "istatistik" yaygın olarak kullanılan bir yönetim ve karar destek aracıdır. Özellikle finansal yönetim, pazarlama yönetimi ve üretim, hizmet ve operasyon yönetiminde uygulanır. İstatistik aynı zamanda yönetim muhasebesi ve denetimde de yoğun olarak kullanılmaktadır. Yönetim Bilimi disiplini, istatistik ve diğer matematiğin iş dünyasında kullanımını resmileştirir. (Ekonometri, ekonomik ilişkilere ampirik içerik kazandırmak amacıyla istatistiksel yöntemlerin ekonomik verilere uygulanmasıdır). ⓘ

Tipik bir "İş İstatistiği" dersi işletme bölümlerine yöneliktir ve tanımlayıcı istatistik (verilerin toplanması, tanımlanması, analizi ve özeti), olasılık (tipik olarak binom ve normal dağılımlar), hipotez testi ve güven aralıkları, doğrusal regresyon ve korelasyonu kapsar; (devam eden) dersler tahmin, zaman serileri, karar ağaçları, çoklu doğrusal regresyon ve daha genel olarak iş analitiğinden diğer konuları içerebilir. Ayrıca bakınız İş matematiği § Üniversite seviyesi. CFA gibi profesyonel sertifika programları genellikle istatistik konularını içerir. ⓘ

Matematiğe veya sanata uygulanan istatistik

Geleneksel olarak istatistik, çoğu bilimde "zorunlu öğrenme" olan yarı standartlaştırılmış bir metodoloji kullanarak çıkarımlar yapmakla ilgiliydi. Bu gelenek, istatistiğin çıkarımsal olmayan bağlamlarda kullanılmasıyla birlikte değişmiştir. Bir zamanlar kuru bir konu olarak görülen ve pek çok alanda diploma gerekliliği olarak alınan istatistik, artık heyecanla karşılanmaktadır. Başlangıçta bazı matematiksel püristler tarafından alay konusu edilen istatistik, artık belirli alanlarda temel metodoloji olarak kabul edilmektedir.

- Sayı teorisinde, bir dağılım fonksiyonu tarafından üretilen verilerin dağılım grafikleri, altta yatan örüntüleri ortaya çıkarmak için istatistikte kullanılan tanıdık araçlarla dönüştürülebilir ve bu da hipotezlere yol açabilir.

- Kaos teorisi ve fraktal geometriyi birleştiren öngörüde bulunan istatistik yöntemleri, video çalışmaları oluşturmak için kullanılabilir.

- Jackson Pollock'un süreç sanatı, doğadaki altta yatan dağılımların sanatsal olarak ortaya çıkarıldığı sanatsal deneylere dayanıyordu. Bilgisayarların ortaya çıkmasıyla birlikte, hareketli video sanatı yapmak ve analiz etmek için bu tür dağılım odaklı doğal süreçleri resmileştirmek üzere istatistiksel yöntemler uygulanmıştır.

- İstatistik yöntemleri, performans sanatında, Markov sürecine dayalı bir kart numarasında olduğu gibi, sadece bazı zamanlarda işe yarayan ve istatistiksel metodoloji kullanılarak durumu tahmin edilebilen öngörüsel olarak kullanılabilir.

- İstatistikler, Iannis Xenakis tarafından icat edilen ve müziğin performansa özgü olduğu istatistiksel ya da stokastik müzikte olduğu gibi, önceden tahmin edilebilen bir sanat yaratmak için kullanılabilir. Bu tür bir sanat her zaman beklendiği gibi ortaya çıkmasa da, istatistik kullanılarak öngörülebilir ve ayarlanabilir şekillerde davranır. ⓘ

Uzmanlaşmış disiplinler

İstatistiksel teknikler, biyoistatistik, hesaplamalı biyoloji, hesaplamalı sosyoloji, ağ biyolojisi, sosyal bilim, sosyoloji ve sosyal araştırma dahil olmak üzere çok çeşitli bilimsel ve sosyal araştırma türlerinde kullanılmaktadır. Bazı araştırma alanları uygulamalı istatistikleri o kadar kapsamlı kullanmaktadır ki özel bir terminolojiye sahiptirler. Bu disiplinler şunları içerir:

- Aktüerya bilimi (sigorta ve finans sektörlerinde riski değerlendirir)

- Uygulamalı bilgi ekonomisi

- Astrostatistik (astronomik verilerin istatistiksel değerlendirmesi)

- Biyoistatistik

- Kemometri (kimya verilerinin analizi için)

- Veri madenciliği (verilerden bilgi keşfetmek için istatistik ve örüntü tanımanın uygulanması)

- Veri bilimi

- Demografi (nüfusların istatistiksel çalışması)

- Ekonometri (ekonomik verilerin istatistiksel analizi)

- Enerji istatistikleri

- Mühendislik istatistikleri

- Epidemiyoloji (hastalığın istatistiksel analizi)

- Coğrafya ve coğrafi bilgi sistemleri, özellikle mekânsal analiz

- Görüntü işleme

- Jurimetrics (hukuk)

- Tıbbi istatistikler

- Siyaset Bilimi

- Psikolojik istatistikler

- Güvenilirlik mühendisliği

- Sosyal istatistikler

- İstatistiksel mekanik ⓘ

Buna ek olarak, kendi özel terminolojisini ve metodolojisini geliştirmiş olan belirli istatistiksel analiz türleri de vardır:

- Bootstrap / jackknife yeniden örnekleme

- Çok değişkenli istatistikler

- İstatistiksel sınıflandırma

- Yapılandırılmış veri analizi

- Yapısal denklem modellemesi

- Anket metodolojisi

- Sağkalım analizi

- Çeşitli spor dallarındaki istatistikler, özellikle de beyzbol - sabermetrics olarak bilinir - ve kriket ⓘ

İstatistik, iş dünyasında ve üretimde de önemli bir temel araçtır. Ölçüm sistemlerinin değişkenliğini anlamak, süreçleri kontrol etmek (istatistiksel süreç kontrolü veya SPC'de olduğu gibi), verileri özetlemek ve veriye dayalı kararlar almak için kullanılır. Bu rollerde anahtar bir araçtır ve belki de tek güvenilir araçtır. ⓘ

İstatiksel değerlendirme

İstatistiksel değerlendirme temelde 4 farklı metot uygulanır:

- Katılım grafikleri,

- Kontrol listeleri,

- Sıklık dağılımı,

- Sıklık çizelgeleri. ⓘ